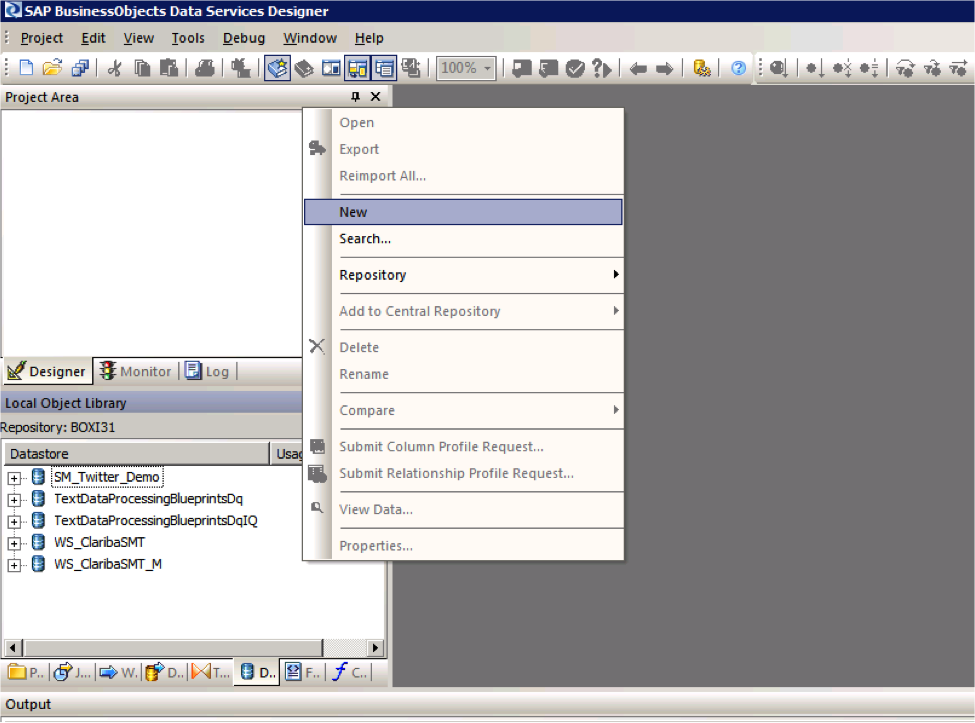

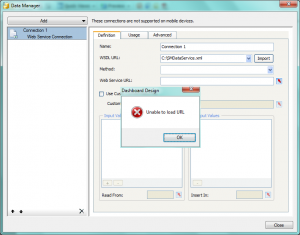

Hace unos meses, un cliente me preguntó cómo ser consciente de los problemas (desconexiones) en los diferentes servidores y servicios de su SAP BO4 SP4 sin necesidad de una persona para comprobar constantemente el estado. Luego comencé a investigar sobre la función de monitoreo en el CMC. La verdad es que no hay demasiada información en la documentación, sólo algunas páginas en la Guía del administrador de la plataforma, o las publicaciones o referencias a este tema en la web. Con este post, intentaré compilar toda esta información que he encontrado y explicaré el uso de estas características interesantes y le daré una breve introducción al monitoreo de CMC.

First of all, let me explain what is CMC monitoring: Monitoring is a new feature of the CMC that appears with SAP BusinessObjects 4 and allows Administrators to see the use and health of the BO system. For this, it uses watches, probes, metrics and alerts. There are some default ones, which allow the Administrator to start playing around with monitoring without a huge knowledge on the topic and obtain really useful information about the status of the system. Before using this feature we need to know the actions we must perform and the existing limitations.

Además, debemos asegurarnos de que la información para el monitoreo se almacene en la base de datos de Monitoreo. Esta es una base de datos Derby y funciona independientemente de los otros dos DBs en SAP BusinessObjects. Para activar la base de datos de monitoreo necesitamos iniciar sesión en el CMC, e ir a Aplicaciones, y hacer doble clic en la Aplicación de Monitoreo. Esto abrirá la ventana Propiedades de la aplicación de supervisión. Asegúrese de que "Activar la aplicación de supervisión" esté marcada. Haga clic en Guardar y cerrar. El paso final es reiniciar el Adaptive Processing Server (APS) si no se ha comprobado. La información de la base de datos se borra cada vez que llegamos a 1 GB de información. Podemos aumentar ese tamaño en el CMC.

Supervisión

Para acceder a la sección de monitoreo de la CMC, debemos ir a Aplicaciones> Monitoreo

Como podemos ver en la imagen anterior, hay 5 diferentes pestañas en esta sección: Dashboards, Metrics, Watchlists, Probes and Alerts. Vamos a correr a través de cada uno:

1. Paneles

es la pestaña predeterminada y como su nombre indica que es un tablero que está dividido en 5 partes:

- Salud en general: Es un icono que muestra si la BO está funcionando correctamente o no.

- Alertas Recientes: Aquí podemos ver las alertas activadas las últimas 24 horas por el sistema.

- Graphical view of BI Landscape: this panel includes a graphical or tabular view of the Watches within the system .We can drill down click in them.

- Estado de KPIs: Esta parte muestra tres Indicadores de Desempeño Clave para el sistema. También podemos profundizar haciendo clic sobre ellos.

- Métricas de nivel de implementación: podemos ver 3 métricas interesantes como los trabajos en ejecución, los usuarios y los trabajos pendientes.

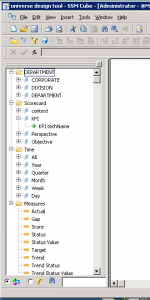

2. Métrica

Las métricas son piezas individuales de información que contribuyen a conocer la salud de los diferentes componentes del sistema.

Las métricas se utilizan para medir la salud de un componente. Las métricas que definimos dependerán de los componentes que estamos monitoreando y de nuestros requerimientos. Ejemplos de métricas son el tiempo de acceso del usuario, el tiempo de ejecución de la consulta, el porcentaje de uso de la CPU, el estado de disponibilidad de un servicio del sistema, etc. Podemos utilizarlos en Relojes y Alertas, estableciendo umbrales para alertas de advertencia y peligro. Hay alrededor de 250 métricas predefinidas. Además, podemos crear nuestras propias métricas si creemos que son necesarias. Normalmente, con los predeterminados, podemos comprobar el estado de casi todo en el sistema.

Si seleccionamos una métrica, podemos observar el estado histórico y actual de la misma.

3. Listas de observación

Esta pestaña nos permite monitorear los relojes que hemos creado. Los relojes son umbrales para las métricas que nos muestran si la métrica está en un estado saludable, de advertencia o en peligro.

Una vez más, hemos creado relojes por defecto. Podemos cambiar estos umbrales para adaptarlos a nuestro sistema. Además, podemos crear notificaciones a los relojes, por lo tanto, podemos pedirle al reloj que envíe un correo electrónico si el sistema está en peligro, por ejemplo. Hay un montón de opciones interesantes con los relojes. Les animo a probarlos por ustedes mismos.

Finalmente, podemos decidir cuáles son los relojes que queremos ver en la pestaña del tablero de instrumentos.

4. Sondas

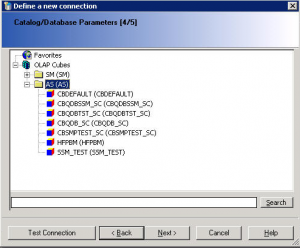

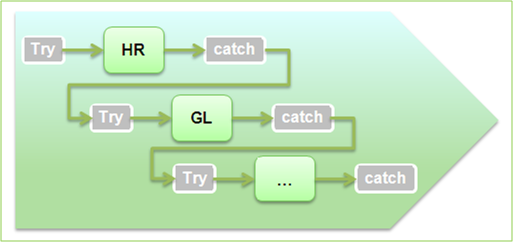

Nos proporcionan la capacidad de monitorear nuestro sistema SAP BusinessObjects, utilizando flujos de trabajo de aplicaciones simuladas que se ejecutan a través de scripts basados en SDK.

Esta es la parte más interesante del monitoreo del CMC pero, al mismo tiempo, el más difícil. Como podemos crear sondas con un SDK, el poder de esta pestaña es enorme. Podríamos crear lo que queramos, pero no es muy fácil crear estas sondas. No hay ejemplos alrededor de la red o son muy difíciles de encontrar. (Voy a tratar de agregar otra entrada en este blog en el futuro con un ejemplo).

As I mentioned before, the system will provide default probes. We can choose among 9, which are:

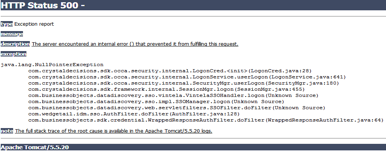

- Sonda de inicio de sesión de inicio de sesión de CMS: supervisa si un usuario puede iniciar sesión con éxito en el sistema SAP BusinessObjects y cuánto tiempo tarda.

- Servicio Crystal Reports a través de la punta de prueba Page and Cache Server: supervisa la disponibilidad y el rendimiento del servicio Crystal Reports (a través de los servidores de página y caché).

- Servicio de Crystal Reports a través de la sonda de Report Application Server: Supervisa la disponibilidad y el rendimiento del servicio Crystal Reports (a través de RAS).

- Sonda Infoview: supervisa la disponibilidad y el rendimiento del inicio de sesión / cierre de sesión de la aplicación web InfoView.

- Sonda de supervisión del servicio de Web Intelligence: comprueba la disponibilidad y el rendimiento del servicio Web Intelligence a través de los servidores de informes.

- Sonda Ping de CMS: Comprueba la funcionalidad principal del CMS.

- CMS Cache probe: Comprueba la disponibilidad de la caché CMS.

- Sonda de conexión de base de datos de CMS: prueba la conexión con el repositorio de CMS.

- Iniciar y detener servidores: prueba para iniciar y detener los distintos servidores del sistema.

5. Alertas

Aquí es donde aparecerán todas las alertas que hemos configurado en la lista de seguimiento.

Esta es una lista de las alertas que el sistema plantea. Podemos ver los diferentes detalles de las alertas al hacer clic en ellos. Estas alertas también pueden enviar correos electrónicos y realizar acciones, dependiendo de lo que hemos establecido en la lista de seguimiento.

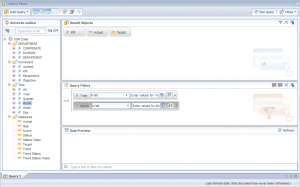

Cómo usar todo en uno

Con toda la información anterior, he explicado una visión general de las diferentes pestañas de la supervisión y también lo que podemos hacer con cada una de ellas.

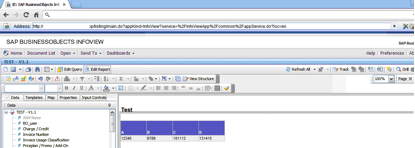

Si queremos aprovechar todo el potencial, es fácil ver que todas las pestañas están conectadas y necesitamos usarlas todas. Un buen ejemplo podría ser el seguimiento del tiempo de respuesta para abrir un informe en el sistema. Para ello, utilizamos la detección "Web Intelligence Service Monitoring" que inicia sesión y tratamos de abrir y actualizar un informe en Web Intelligence. Después de esto, usamos la métrica del tiempo que lleva al sistema ejecutar la sonda y la métrica que dice si la sonda fue exitosa o no. Además, creamos un whatchlist con esta métrica y si las sondas tardan más de 5 segundos, enviará un correo electrónico informando al Administrador que el sistema está funcionando un poco lento y si la sonda falla o tarda más de 15 segundos , Enviará otro correo electrónico informándole que el sistema no funciona correctamente. Podemos programar esta sonda para que se ejecute diariamente.

Con este escenario simple somos capaces de detectar cualquier problema en el sistema automáticamente, antes de que cualquier usuario lo informe. Además, las alertas de las pestañas nos mostrarán si hay algo malo que no habíamos notado antes.

Conclusión

Como conclusión, podemos ver que al jugar con todas estas características, podemos lograr cosas realmente interesantes y obtener la mayoría de todo bajo control en nuestro sistema BO. Podría parecer difícil de aprender, pero hay muchas cosas que podemos hacer sólo con la configuración predeterminada. Después de acostumbrarse a ellos, es hora de jugar con el poder de las sondas auto-creadas y agregar más opciones personalizadas a nuestro monitoreo.

Espero que esta introducción al monitoreo le haya ayudado a entender un poco más cómo CMC Monitoring funciona en SAP BO 4 SP4.

Si tiene alguna pregunta o sugerencia, por favor deje un comentario a continuación.