The impact and value of data are key issues for many companies. Information volume grows exponentially every day and that growth is forecast to continue. It is estimated that companies will create 60% of information worldwide by 2025.

La información es, por tanto, un activo muy valioso para cualquier empresa, fundamental para la toma de decisiones y acciones. Pero pierde todo su valor si no se puede garantizar la calidad de los datos.

Data quality is a set of processes by which data is processed to ensure its reliability and rigor.

En un mundo posterior a COVID-19, la confianza se ha convertido en un activo fundamental, y las empresas que sean capaces de generar una relación de confianza con sus clientes volverán a un crecimiento ininterrumpido mucho más rápido.

La fiabilidad de sus datos, por tanto, se convierte en un factor decisivo para el futuro de la empresa y su capacidad para mantener esa relación de confianza con los clientes.

1. Resumen del proceso

En Clariba sabemos la importancia de la calidad para garantizar los mejores resultados. Por ello, recientemente hemos creado un proceso con uno de nuestros clientes en el que automatizamos el aseguramiento de la calidad de sus datos. Es fácil de implementar y de usar.

Todo el proceso se basa en una serie de reglas de configuración que indican las tablas y campos a los que se va a aplicar el aseguramiento de la calidad, y mediante una serie de procedimientos se realiza la limpieza y homogeneización de los datos.

Primero, se leen los datos y se aplican las acciones de limpieza previamente analizadas y definidas, donde se pueden establecer condiciones como cambiar el tipo de dato o borrar, modificar o reemplazar cualquier carácter.

Una vez corregido, se aplica la homogeneización para dotar a los datos de la fiabilidad y robustez final requerida.

Finalmente, validamos que estos datos sean correctos para garantizar la calidad. Por ello, analizamos cada dato para verificar que la limpieza y homogeneización sea precisa, y si se detecta una falla, registramos esa falla detallada para poder revisar el caso y corregirlo.

Pueden ocurrir fallas porque la homogeneización se realiza mediante cruces de relaciones para recuperar el valor correcto. Si alguno de estos cruces falla, suele ser porque hay una nueva relación causal, y esta debe definirse para corregirla.

La estructura completa de este proceso se detalla a continuación en una guía paso a paso.

2. Guía paso por paso

El primer paso es crear la tabla de configuración de limpieza principal, donde detallamos a qué procesos ETL se aplicará la calidad de los datos. Además, se indica la tabla de origen, para recuperar los nombres y tipos de campos, la tabla de destino, donde se almacenarán los datos limpiados, el nombre de la tabla que se generará para aplicar las acciones a cada uno de los campos en el tabla de origen y, finalmente, el nombre de la tabla donde se almacena la información sobre qué campo se aplicará a qué acción de limpieza.

Tabla 1: tabla de configuración de limpieza principal

Una vez que tenemos la primera tabla de configuración completa un procedimiento automatizado lee la tabla y crea tantas tablas de limpieza como se definan en la configuración. Estas serán las tablas que se generen para, a través de parámetros predefinidos, las acciones de limpieza que indiquemos que se les apliquen. De forma predeterminada, todos los parámetros se establecen en "0", y para que el proceso aplique una acción específica, el valor debe actualizarse a "1".

Las tablas de limpieza se verán así:

Tabla 2: tabla generada para aplicar la limpieza

When cleaning the data, it is useful to establish a standard in each type of field to facilitate homogenization. For example, all fields of type varchar must be capitalized with spaces, accents, or special characters removed. Or if it is a date type, convert all dates to the same format.

Además, se debe configurar la lista maestra de acciones a aplicar. Esta tabla especifica el nombre de la acción de limpieza y las funciones en lenguaje SQL para aplicar a los campos. Para determinadas funciones, es posible que el campo deba leerse solo una o varias veces.

La siguiente tabla muestra dos ejemplos:

Tabla 3: mesa maestra de funciones de limpieza

Una vez establecidas todas estas tablas, el siguiente paso es generar la tabla de acciones a través de la cual se aplicarán todos los cambios a los campos seleccionados.

Tabla 4: table de limpieza final

Por último, se lee la tabla de destino de la Tabla 1 y se hace una referencia cruzada de la información con la tabla de acciones para devolver todos los datos limpios antes de iniciar el siguiente proceso.

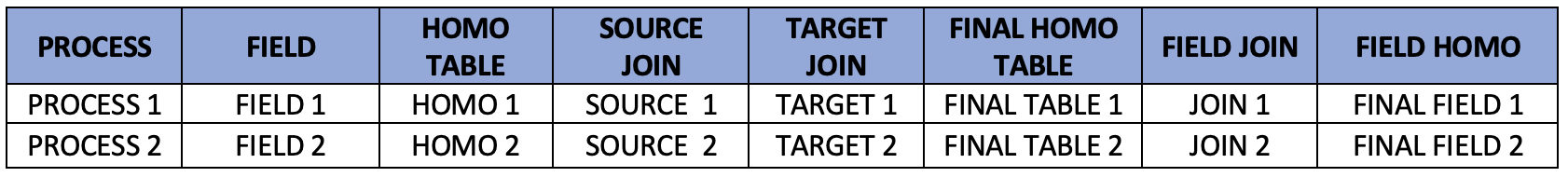

El siguiente paso es la homogeneización. Al igual que con el proceso de limpieza, primero debemos definir la tabla de configuración principal. En este caso, tenemos los detalles del proceso, la tabla de origen y la tabla de destino.

Tabla 5: table principal de homogeneización

Junto con la tabla principal, hay otra tabla con detalles de qué campos se van a homogeneizar y dentro de qué tablas se va a recuperar el valor correcto.

Tabla 6: table de homogeneización

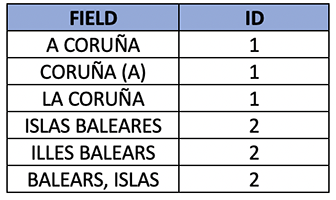

Es necesario tener las tablas de homogeneización con mayor número de casos para cada uno de los campos. Es decir, a través de relaciones, se recupera un código que se utiliza para hacer una última coincidencia con el valor correcto.

Un caso ilustrativo es el campo de provincia que se muestra a continuación, donde se nos puede informar de la misma provincia de diferentes maneras. Con la limpieza, capitalizamos y eliminamos espacios, acentos y caracteres especiales en el nombre de la provincia.

Primero, hacemos una referencia cruzada de la información recuperando el identificador, y luego devolvemos de la tabla maestra el valor correcto correspondiente a ese identificador.

Tabla 7: tabla de relaciones

Tabla 8: tabla maestro de provincias

En este punto, los datos están casi listos para trabajar, pero primero debemos validar que la calidad de los datos sea correcta. Para ello, hacemos una referencia cruzada de los datos con las tablas maestras de cada campo estandarizado y verificamos que los valores sean correctos.

Si hay datos que no se pudieron estandarizar, se mantiene una tabla donde se registran todas las fallas, que contiene información detallada sobre el proceso al que corresponde, el campo y valor que no se pudo estandarizar, y la fecha.

En los casos en los que se detecte que un valor no se pudo estandarizar, se debe ingresar en la tabla de homogeneización para que la próxima vez se pueda procesar sin errores.

Finalmente, todo el flujo del proceso se detalla visualmente:

Como hemos visto, crear un proceso de calidad de datos es relativamente sencillo. Aunque requiere una cantidad apreciable de tiempo y recursos para su instalación, el valor agregado al negocio al poder garantizar la calidad, confiabilidad y homogeneidad de todos los datos supera con creces este costo inicial.

Y con el crecimiento expansivo de los datos producidos por organizaciones de todos los tamaños que sigue aumentando, nunca ha habido un mejor momento para poner su casa en orden en lo que respecta a la calidad de los datos. Poner los sistemas correctos en su lugar ahora ahorrará mucho más esfuerzo en el futuro.

Si desea obtener más información sobre cómo configurar un proceso de garantía de calidad para los datos que maneja y almacena su organización, estaremos encantados de analizar sus opciones. Contáctenos a través de los detalles a continuación para programar una reunión.